У США зафіксували унікальний випадок

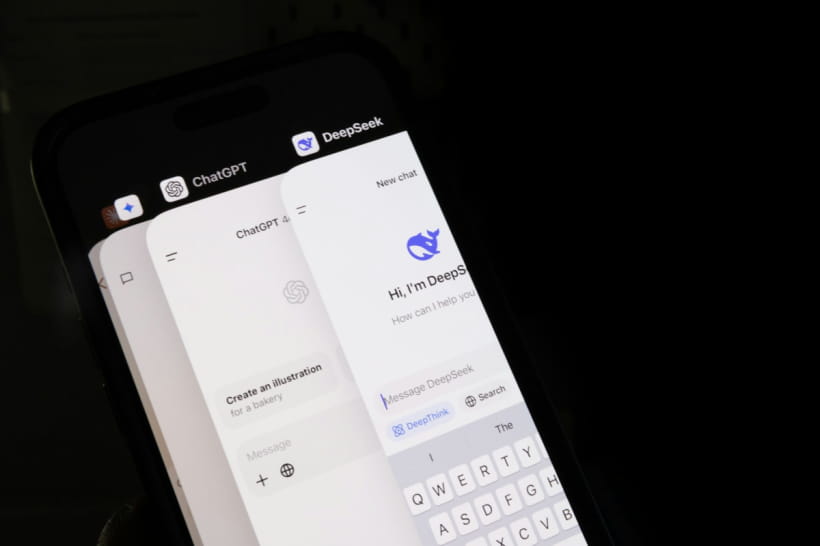

Лікарі з Університету Вашингтона зафіксували перший задокументований випадок отруєння, спричиненого рекомендаціями штучного інтелекту. Про це повідомляє "Дивогляд" із посиланням на Gizmodo.

Пацієнтом виявився чоловік, який протягом трьох місяців дотримувався порад ChatGPT щодо харчування. Він почав регулярно вживати натрію бромід – токсичну речовину, яку сприйняв як безпечну альтернативу кухонній солі. У результаті в нього розвинувся бромізм, що призвів до тяжкого психозу. Після тривалого лікування стан вдалося стабілізувати, і пацієнт одужав.

Все почалося з того, що чоловік потрапив до лікарні, підозрюючи, що його отруїв сусід. Медики зафіксували у нього підвищену збудливість, параноїдальні думки, галюцинації та відмову від пиття води, навіть при сильній спразі. Згодом симптоми переросли в гострий психотичний епізод, і пацієнта помістили на примусову ізоляцію у психіатричне відділення.

Після початку інтенсивної терапії внутрішньовенними розчинами та антипсихотичними препаратами чоловік зміг пояснити, що отруєння пов’язане з його дієтою. За його словами, прагнучи зменшити споживання натрію хлориду через його шкоду для здоров’я, він попросив ChatGPT порадити безпечний замінник.

Нейромережа, за його словами, вказала на натрію бромід як на можливу альтернативу, не пояснивши небезпеку його вживання. Чоловік замовив речовину онлайн і вживав її регулярно.

Лікарі підкреслили, що в типових контекстах така рекомендація могла стосуватися не харчування, а технічних чи побутових процесів, однак ChatGPT не уточнив, для чого пацієнт цікавиться бромідом, і не попередив про його токсичність. Експерти вважають, що це суттєвий недолік у роботі системи.

Хоча медики не змогли отримати повну історію листування пацієнта з чат-ботом, під час власної перевірки ChatGPT 3.5 вони справді отримали відповідь, де бромід вказувався як заміна хлориду – без прямої згадки про загрозу для здоров’я при споживанні.

Після трьох тижнів у лікарні та двох тижнів спостереження після виписки пацієнт залишився у стабільному стані. Лікарі наголосили, що випадок має стати уроком: навіть найсучасніші ШІ-системи можуть поширювати неточну або небезпечну інформацію, а поради з питань здоров’я мають надаватися лише кваліфікованими медичними спеціалістами.

Раніше "Дивогляд" розповідав, що ваші запити до ChatGPT можуть призвести до проблем із законом.

Чудернацькі історії з України, котики, скандали світових зірок, гумор і трохи дикого трешу з московських боліт – читайте першими в Telegram Дивогляд 5.UA.