В США зафиксировали уникальный случай

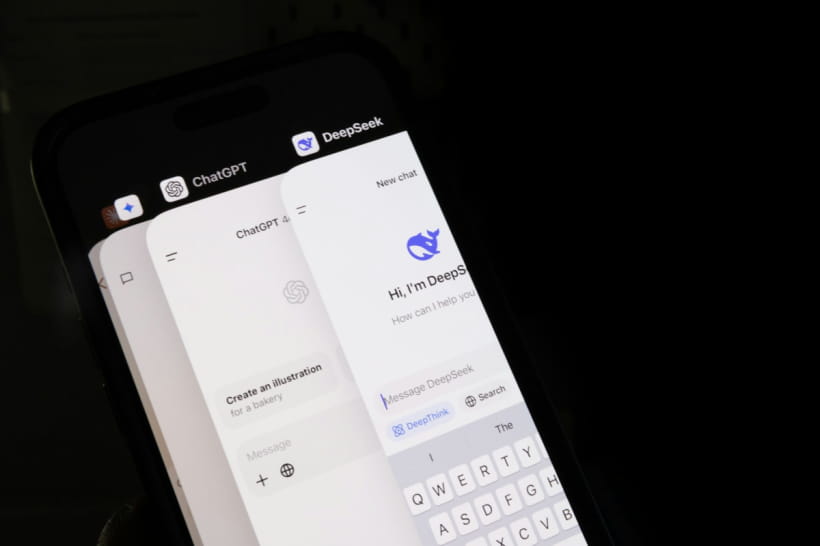

Врачи из Университета Вашингтона зафиксировали первый документированный случай отравления, вызванного рекомендациями искусственного интеллекта. Об этом сообщает "Дивогляд" со ссылкой на Gizmodo.

Пациентом оказался мужчина, который в течение трех месяцев следовал советам ChatGPT по питанию. Он начал регулярно употреблять бромид натрия – токсическое вещество, которое воспринял как безопасную альтернативу поваренной соли. В результате у него развился бромизм, приведший к тяжелому психозу. После продолжительного лечения состояние удалось стабилизировать, и пациент поправился.

Все началось с того, что мужчина попал в больницу, подозревая, что его отравил сосед. Медики зафиксировали у него повышенную возбудимость, параноидальные мысли, галлюцинации и отказ от питья воды даже при сильном жажде. Впоследствии симптомы переросли в острый психотический эпизод и пациента поместили на принудительную изоляцию в психиатрическое отделение.

После начала интенсивной терапии внутривенными растворами и антипсихотическими препаратами мужчина смог объяснить, что отравление связано с его диетой. По его словам, стремясь снизить потребление натрия хлорида из-за его вреда для здоровья, он попросил ChatGPT посоветовать безопасный заменитель.

Нейросеть, по его словам, указала на натрия бромид как на возможную альтернативу, не объяснив опасности его употребления. Человек заказал вещество онлайн и употреблял его регулярно.

Врачи подчеркнули, что в типичных контекстах такая рекомендация могла касаться не питания, а технических или бытовых процессов, однако ChatGPT не уточнил, для чего пациент интересуется бромидом и не предупредил о его токсичности. Эксперты полагают, что это существенный недостаток в работе системы.

Хотя медики не смогли получить полную историю переписки пациента с чат-ботом, во время проверки ChatGPT 3.5 они действительно получили ответ, где бромид указывался как замена хлорида – без прямого упоминания об угрозе для здоровья при потреблении.

После трех недель в больнице и две недели наблюдения после выписки пациент остался в стабильном состоянии. Врачи подчеркнули, что случай должен стать уроком: даже самые современные ШИ-системы могут распространять неточную или опасную информацию, а советы по здоровью должны предоставляться только квалифицированными медицинскими специалистами.

Ранее "Дивогляд" рассказывал, что ваши запросы к ChatGPT могут привести к проблемам с законом.

Причудливые истории из Украины, котики, скандалы мировых звезд, юмор и чуть-чуть дикого трэша из московских болот – читайте первыми в Telegram Дивогляд 5.UA.